Salah satu cara untuk memblokir search engine (Google, Yandex, MSN, Yahoo, dll) dengan memanfaatkan robots.txt. Bila biasanya anda membuat file robots.txt secara manual, dengan menambah konfigurasi di nginx bisa tanpa perlu menambah file apapun.

Konfigurasi Robots.txt

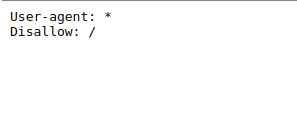

Konfigurasi standart untuk memblokir semua mesin pencari dengan robots.txt

User-agent: * Disallow: /

Untuk memblokir hanya mesin pencari Bing

User-agent: BingBot Disallow: /

Untuk memblokir hanya mesin pencari Google

User-agent: GoogleBot Disallow: /

Setting Robots.txt di Nginx

Di konfigurasi nginx untuk domain anda, tambahkan

location = /robots.txt { add_header Content-Type text/plain; return 200 "User-agent: *\nDisallow: /\n"; }

cek konfigurasi anda

nginx -tbila tidak ada error, reload nginx

systemctl reload nginx

Buka http://nama-domain/robots.txt

Penutup

Dengan memblokir search engine di robots.txt tidak serta merta langsung menghilangkan website anda dari index mesin pencari, karena itu tergantung dari mesin pencari apakah mereka mengikuti aturan main robots.txt atau tidak. Untuk Google sendiri, biasanya 1-2 minggu setelah setting robots.txt ini website anda akan hilang dari Google.

Solusi lain agar website anda tidak bisa diindex oleh mesin pencari adalah dengan menambahkan Basic Auth